Технологии freesync и g sync amd freesync что это

FreeSync против G-Sync: что лучше?

G-Sync и FreeSync могут вывести гейминг на новый уровень, но какая из технологий лучше?

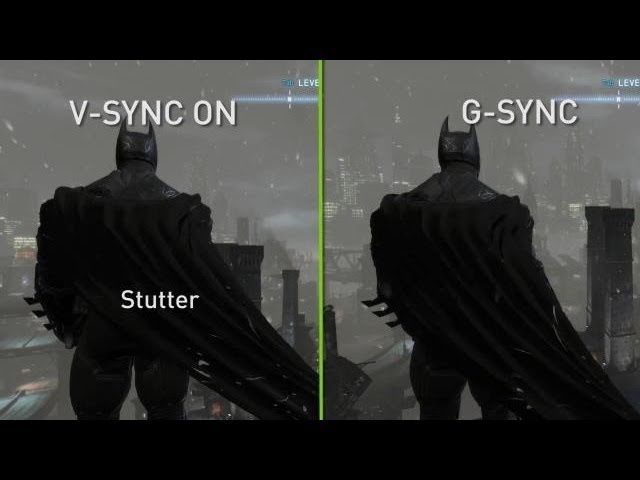

Если вы когда-либо наблюдали разрывы экрана при игре на ПК, то знаете, насколько это раздражительно. В таком случае идеально разработанная видеоигра становится испорченной грубыми горизонтальными линиями и заиканием. Вы можете включить V-Sync, однако при отсутствии действительно высокопроизводительной системы, это может сильно повлиять на общую производительность.

И Nvidia, и AMD усилили попытки решить эту проблему, сохранив частоту кадров, и оба производителя обратились к технологии адаптивной синхронизации, чтобы наконец решить столь глобальную проблему. Но давайте разберемся, чтобы выяснить, какой же вариант все-таки лучше.

Производительность

G-Sync и FreeSync предназначены для сглаживания игрового процесса, уменьшения задержки ввода и предотвращения разрывов экрана. Обе технологии используют разные методы для достижения данных целей, но на самом деле их отличает то, что одна из них тщательно охраняется, а вторая — используется в открытую. В то время как G-Sync от Nvidia добавляется путем включения чипа в конструкцию монитора, FreeSync использует функциональность видеокарты для управления частотой обновления монитора, используя стандарт Adaptive Sync, встроенный в стандарт DisplayPort, — в результате имеем разницу в производительности.

Пользователи отмечают, что, хотя разрыв и заикание уменьшаются при включенной FreeSync, некоторые мониторы имеют еще одну проблему: эффект Ghosting. Суть его заключается в том, что, когда объекты движутся по экрану, то оставляют изображения своей последней позиции, и это выглядит как тень. Это баг, которого некоторые люди вообще не замечают, но это действительно раздражает.

FreeSync и G-Sync также испытывают проблемы, когда частота кадров не синхронизируется постоянно в пределах диапазона обновления монитора. G-Sync имеет проблемы с мерцанием при очень низкой частоте кадров, и, хотя технология обычно компенсирует это, есть исключения. FreeSync, тем временем, имеет проблемы с заиканием, если частота кадров падает ниже заявленной минимальной частоты обновления монитора. Некоторые мониторы с FreeSync имеют чрезвычайно узкий диапазон адаптивной синхронизации, и если ваша видеокарта не может обеспечивать частоту кадров в этом диапазоне, возникают проблемы.

Кажется, что большинство пользователей, сравнивших две технологии, все же предпочитают качество G-Sync, которое не показывает проблем с заиканием при низкой частоте кадров и, таким образом, является более плавной в реальных ситуациях.

Выбор

Одним из первых отличий, о котором вы услышите, когда речь заходит о технологии адаптивной синхронизации, помимо общего соперничества между AMD и Nvidia, является разница между закрытым и открытым стандартом. Хотя G-Sync является запатентованной технологией Nvidia и требует разрешения компании и сотрудничества, FreeSync бесплатна, и её реализация — цель программы, а не способ заработать деньги. Таким образом, с поддержкой FreeSync доступно больше мониторов.

С другой стороны, G-Sync существует дольше, и она управляется Nvidia, нынешним лидером в производстве графических процессоров. Это может помешать расширению лидерства AMD в совместимых мониторах, но сейчас технология все еще имеет преимущество.

В большинстве случаев вы не можете смешивать и сочетать две технологии. Хотя сами мониторы будут работать независимо от марки видеокарты, для функций FreeSync и G-Sync конкретно требуется графический процессор AMD и Nvidia соответственно. Вы должны выбрать Nvidia или AMD, а затем приобрести монитор соответственно.

Если вы предпочтете Nvidia, модуль на мониторе будет выполнять большую часть тяжелой работы, связанной с регулировкой частоты обновления. Это будет отражено на цене за дисплей, поскольку каждый производитель должен платить Nvidia за технологию. Положительным моментом является то, что эта технология была выпущена еще в начале 2014 года, поэтому она доступна даже на мониторах по цене от 28 000 рублей, например, Acer Predator XB241H.

Модуль G-Sync также выполняет большую часть тяжелой работы, поэтому, пока монитор совместим, вы можете использовать карты младшего поколения. Nvidia перечисляет совместимые опции, которые варьируются от Titan X и 1080 Ti до 1050, цены на которых стартуют от 9 500 рублей.

Вы не будете платить больше за монитор с FreeSync. В отличие от G-Sync, производитель не может увеличивать цену за включение технологии. Таким образом, FreeSync часто поставляется в дисплеях с 1440p и частотой обновления 144 Гц (там, где нет аналогов G-Sync), а мониторы без этих функций могут стоить всего около 10 000 рублей.

Вам также понадобится карта с поддержкой FreeSync, которая традиционно была присуща только видеокартам AMD, а также APU и консолям, таким как Xbox One, которые используют AMD APU. Но это традиционное разделение между G-Sync и FreeSync теперь стало более размытым благодаря видеокартам от Nvidia, способным поддерживать FreeSync.

Все это стало возможным из-за обновления драйвера, которое позволяет графическим картам серии GeForce GTX 10, GeForce GTX 16 и GeForce RTX 20 работать с мониторами на FreeSync. Обычно он работает, но есть одна загвоздка — гарантированно работа обеспечена только на мониторах FreeSync, которые сертифицированы как совместимые с Nvidia G-Sync. Это означает, что карты были тщательно протестированы и одобрены Nvidia для обеспечения бесперебойной работы FreeSync по всему диапазону. Вот текущий список сертифицированных мониторов

Заключение

Без каких-либо других компонентов вы потратите не менее 28 500 рублей на монитор с G-Sync (1080p) и графическую карту GTX 1050; гораздо больше, если вы хотите устройство, которое может обрабатывать 4K-игры. И все же за менее чем 19 000 рублей вы можете достичь базового уровня совместимости FreeSync с Asus VG245H, упомянутым выше, и картой, подобной Radeon RX 550, которая запустит игры в 1080p с достойной производительностью. Хорошей новостью для AMD является то, что вплоть до RX 580 (которая является отличной видеокартой для игр в 1440p), цены вполне сопоставимы с периферией Nvidia. Это означает, что вы сможете получить столь же мощный графический процессор без G-Sync Premium.

Учитывая ценовой разрыв, вы можете задаться вопросом, почему кто-то предпочел бы G-Sync. Ответ прост – она лучше. Технология адаптивной синхронизации от Nvidia обеспечивает более стабильную общую производительность. Стоит также отметить, что, когда речь заходит о высокой производительности и играх в 4K, видеокарты Nvidia в настоящее время являются настоящим королем производительности. Переход на FreeSync и, следовательно, покупка графического процессора AMD Radeon, может означать покупку оборудования, которое обеспечивает меньшую отдачу от затраченных средств.

К счастью, новая совместимая с G-Sync программа предоставляет покупателям множество новых возможностей. Если вы уже обладаете картой Geforce GTX 10-й серии и выше, то можете купить более дешевый монитор с FreeSync, который уже сертифицирован для работы с картой.

В конечном итоге обе технологии в значительной степени достигают своих целей и предоставляют опыт, превосходящий V-Sync. Ваш выбор будет зависеть от того, предпочитаете ли вы общую эффективность, или же первоклассный игровой опыт.

Что такое G-Sync, FreeSync, V-Sync и HDMI VRR? — Разбор

Всех ПК-геймеров планеты Земля, да и консольных игроков тоже, объединяет одна проблема — вертикальные разрывы изображения. И вроде бы есть куча технологий которые решают эту проблему:

Давайте сегодня раз и навсегда разберемся в технологиях адаптивной синхронизации изображения.

Для тех кто не в курсе. А в чём собственно проблема?

Чтобы изображение появилось на экране, должно произойти, как минимум, две вещи:

Обычные мониторы работают на частоте 60 Гц, то есть способны выводить 60 кадров в секунду, а игровые на 144 Гц и выше.

А вот графический процессор живет в совершенно ином мире. В играх постоянно всё меняется: колышется листва, журчит ручеёк, враги выпрыгивают из-за угла. Каждый кадр отличается по своей сложности, поэтому на их просчет уходит разное количество времени.

Иными словами, у монитора частота кадров постоянная, а у видеокарты переменная.

Вот и выходит, что за один цикл обновления монитора видеокарта может подготовить больше одного кадра или меньше.

Из-за этого мало того что страдает плавность картинки, так еще и появляются артефакты в виде вертикальных разрывов изображения. Кстати, при просмотре фильмов тоже могут появляться такие артефакты, потому что кино снимают в 24 к/с.

V-Sync

Очевидно проблема требовала решения, и еще на заре компьютерных игр оно появилось! Название у этого решения — вертикальная синхронизация или V-Sync. Наверняка вы встречали такую опцию как в настройках видеокарты, так и в играх.

Работает эта штука достаточно топорно. Фактически она просто принуждает видеокарту выводить кадры с частотой кратной частоте обновления экрана. Например, если у вас монитор 60 Гц, то максимальное количество кадров в секунду тоже будет 60, даже если ваша видеокарта способна на большее. И в общем-то часто такое ограничение вполне уместно, если у видеокарты хватает мощи и нет просадок ниже 60 к/с, но если они есть — начинаются проблемы.

При включенной вертикальной синхронизации, следующее кратное значение — это 30 к/с. Поэтому даже если ваш фреймрейт просел фактически всего на пару кадров, вы всё равно увидите падение до 30 к/с. Такой перепад мало того, что большой и очень визуально ощутимый, так ещё и будет происходить с небольшим лагом. Поэтому если стабильного FPS в 60 к/с или 30 не достичь, то включать V-Sync вообще нет никакого смысла.

Справедливости ради, чем выше герцовка монитора, тем больше мы имеем кратных значений, на которых может работать синхронизация. Поэтому на игровых мониторах V-Sync работает куда лучше.

Но история с кратными значениями — не самая главная проблема технологии. Есть другой неочевидный недостаток: вертикальная синхронизация — увеличивает задержку ввода, то есть создаёт Input Lag.

Игра медленнее реагирует на ваши действия, всё происходит с задержками и как-то плывёт в молоке, поэтому прицелиться становится гораздо сложнее. Почему так происходит?

Это интересно, смотрите! Каждый кадр рассчитывается и выводится на экран через один и тот же конвейер. Упростим его до трёх этапов.

Ну и в чём проблема, спросите вы? Дело в том, что ЦП не берется за подготовку следующего кадра, пока предыдущий не будет выведен на экран. Поэтому ограничивая количество выводимых кадров в угоду синхронизации с дисплеем, мы фактически увеличиваем задержки с которыми обновляется состояние игры! И если в каких-то простеньких играх типа пасьянса такие вещи допустимы, то в соревновательных играх вертикальная синхронизация может стать серьёзной помехой.

G-Sync

Но переживать не стоит, так как решение появилось еще в 2013 году. Именно тогда компания NVIDIA представила свою технологию адаптивной синхронизации — G-Sync. В отличие от старой технологии, G-Sync позволяет подстраивать не видеокарту под частоту обновления монитора, а наоборот заставляет монитор менять свою частоту под видеокарту!

Представляете? Так тоже можно было!

В результате мы получаем потрясающе плавную картинку без вертикальных разрывов и задержки ввода! Просто сказка! G-Sync также работает в огромном диапазоне частот. Изначально это было от 30 до 144 Гц, а сейчас уже есть поддержка до 360 Гц и может даже выше, тут скорее всё зависит от монитора.

А если фреймрейт падает ниже 60 Гц G-Sync умеет дублировать пропущенные кадры.

Получаются сплошные плюсы и проблема решена еще в 2013 году? Так почему же мы до сих пор об этом говорим?

Ну как сказать. Во-первых, эта технология закрытая, соответственно, G-Sync работает только с карточками NVIDIA, но это пол беды.

Все волшебные функции G-Sync стали возможны благодаря специальному чипу, который необходимо встроить в монитор. Естественно, эти чипы производит тоже NVIDIA и стоят они недешево. Поэтому мониторы с поддержкой G-sync в среднем стоят на 250-300$ дороже и таких моделей очень мало. То есть получилась классная, и для 2013 года революционная технология, но не универсальная и дорогая.

VESA Adaptive Sync

Поэтому уже спустя год, в 2014, Ассоциация стандартизации Video Electronics Standards Association или VESA представила открытую технологию Adaptive Sync, которая умеет, в принципе, всё то же самое, что и G-Sync, но без дорогостоящих чипов и работает на частотах от 9 до 240 Гц! Неплохо да?

Но для внедрения технологии нужно, чтобы её поддержку внедрили в прошивку и драйвер монитора, драйвер видеокарты, операционной системы и в игры!

А также необходимо наличие DisplayPort версии не ниже 1.2a, так как технология стала частью именно Display Port. Как видите, чтобы технология взлетела, нужно было проделать много работы. И этой работой занималась компания AMD.

AMD FreeSync

В 2015 году AMD внедрили Adaptive Sync в драйвера своих видеокарт и назвали технологию FreeSync. Реализация от AMD быстро получила очень широкое распространение. Добавить поддержку FreeSync в монитор оказалось настолько дешево, что сейчас сложнее найти игровой монитор без этой фичи, чем с ней.

Но AMD не остановились на просто внедрении стандарта от VESA. Также они добавили поддержку HDMI, начиная с версии 1.4. А в 2017 выпустили FreeSync 2, в который добавилась поддержка HDR и компенсацию низкой частоты кадров, как в G-SYNC.

Кстати, чуть позже, FreeSync 2 переименовали в более элитное FreeSync Premium Pro, а обычный FreeSync для мониторов с частотой 120 Гц и выше стали называть FreeSync Premium. Хотя такие маркетинговые финты я не одобряю, но в остальном сплошной респект AMD за популяризацию стандарта.

Кстати, NVIDIA также в 2017 году добавила поддержку HDR и назвала это всё G-Sync Ultimate.

И вроде бы всё классно, в команде у красных и у зеленых есть по своей шикарной технологии. Но что делать, если у тебя видеокарта от NVIDIA, ты хочешь нормальную поддержку G-Sync, но покупать дорогущий монитор с этой технологией совсем не хочется? Или наоборот — не покупать же Radeon только потому что у тебя монитор с FreeSync?

G-Sync Compatible

Но в 2019 году NVIDIA пошли навстречу покупателям и добавили поддержку стандарта VESA Adaptive Sync в драйвера для своих видеокарт серии RTX, а также для карточки GTX 1080. А значит теперь можно легко насладиться лучшим из двух миров: взять себе карточку от NVIDIA и монитор с FreeSync по вкусу. Вот только есть проблема. Если на FreeSync мониторе не написано G-Sync Compatible — значит он не был протестирован NVIDIA на совместимость и никаких гарантий, что всё будет работать нормально, вам никто не даёт. А NVIDIA тестирует далеко не все, и далеко не самые доступные модели.

Поэтому инициативу по тестированию в свои руки взяло интернет-сообщество. Они составили табличку с огромным списком протестированных пользователями мониторов.

Причём всё будет работать и с видеокартами от NVIDIA и с Radeon. Всё потому, что VRR — это та же самая технология VESA Adaptive Sync, но теперь она стала ещё и частью стандарта HDMI 2.1. Именно таким образом адаптивная синхронизация реализована в консолях нового поколения. А также, вы удивитесь, в Xbox One S и One X. Да, в коробки текущего поколения от Microsoft VRR завезли даже раньше, чем HDMI 2.1.

Итоги

Что, в итоге спустя 6 лет после своего появления, технология Adaptive Sync стала фактически отраслевым стандартом. Захватив видеокарты от AMD и NVIDIA, телевизоры и даже интегрированная графика от Intel в 11-м поколении процессоров теперь поддерживает эту технологию. А это значит, что в светлом будущем мы будем жить без единого разрыва, по крайней мере, вертикального!

Разбираемся, что такое G-Sync, FreeSync, V-Sync и нужны ли они вообще

Связь видеокарты с монитором и её проблемы

В идеальном случае эти два отрезка времени должны быть равны — тогда, когда на мониторе закончится старый кадр, к нему подоспеет новый кадр и они плавно пойдут друг за другом, не создавая проблем. Но видеокарта может «обгонять» монитор.

И тут необходимо понимать, что мониторы работают с определёнными частотами обновления — количеством обновления кадров в секунду. Измеряется частота обновления в герцах. Мониторы с 60 Гц обновляют картинку 60 раз за секунду, 144 Гц — 144 раза за секунду.

Возвращаясь к видеокарте и монитору — значение кадров в секунду, выходящих из видеокарты, плавает, и может быть как меньше 60, так и больше. Оба случая приводят к проблемам.

Обратный вариант: видеокарта рендерит больше кадров в секунду, чем способен показать монитор. Это приводит к тому, что на мониторе может появиться сразу несколько кадров.

Подобные разрывы бросаются в глаза, и их частое появление может вызвать тошноту, боль в глазах или головокружение. В таком случае речь идёт не просто о плавной игре, но и о здоровье человека, потому борьбе с подобным уделено большое внимание. Ниже рассмотрены методы синхронизации видеокарты и монитора, которые позволяют избавиться от подобных проблем.

Вертикальная синхронизация — дёшево и сердито

Тем не менее, не решается проблема и с кадрами, которые рендерятся дольше и из-за которых видеокарта выдаёт в секунду меньше, чем может показать монитор. Потому что V-Sync в таком случае сокращает число выводимых кадров до кратного частоте монитора. Например, если у вас монитор с 60 Гц, а видеокарта выводит 55 кадров в секунду, то V-Sync срежет выводимое число кадров до 30, чтобы картинка шла плавнее. В результате FPS падает и ощущения становятся ещё хуже.

Адаптивная синхронизация — старший брат V-Sync

Однако на практике подобный метод помогает не всегда и проблемы вертикальной синхронизации всё ещё могут встречаться.

G-Sync — дорого, но эффективно

Убирая все минусы вертикальной синхронизации (статтеринг, разрыв изображения, задержку управления), G-Sync является очень хорошим вариантом. Но, вместе с этим, очень дорогим, так как G-Sync работает только на мониторах с предустановленным чипом от Nvidia и требует повышенной мощности.

FreeSync — упрощённая G-Sync

Однако свои отличия есть. Если G-Sync продолжает работать по этому принципу на низких FPS, мониторы с FreeSync начинают использовать «традиционные» методы синхронизации, возвращая старые помехи — и статтер, и разрыв изображения, и задержку управления.

Но если G-Sync использует свой собственный чип, FreeSync работает на DisplayPort — уже разработанной до этого технологии. Говоря кратко: для FreeSync тоже нужен специальный монитор, но FreeSync-монитор будет дешевле монитора с G-Sync.

VRR и совместимость FreeSync с G-Sync

Это значительно расширяет список подходящих мониторов, а также даёт шанс, что любой монитор сможет работать с G-Sync.

Играем по-новому. G-sync и FreeSync – особенности и отличия

Геймеры знают, что если не найти баланс между производительностью графической карты и возможностями монитора, то в играх могут появиться визуальные артефакты (разрывы изображения). Причина их появления — не совпадение частоты кадров видеокарты и частоты обновления дисплея. Единственным выходом было включение функции Vsync, чтобы синхронизировать частоты между собой, правда, это не решало проблему на 100%. Поэтому в 2014 году NVIDIA и AMD представили свои решения адаптивной частоты обновления экрана, которые мы рассмотрим в этом материале.

Большинство мониторов работает при фиксированной частоте обновления – 60, 120 или 144 Гц, к примеру. При запуске 3D игры частота кадров (Frames per Second, FPS) будет «плавать» в определенном диапазоне в зависимости от того насколько ПК справляется с нагрузкой. По умолчанию графическая карта отправляет монитору кадры, как только они были обработаны, независимо от того, готов ли дисплей отобразить следующий кадр. Поэтому при частоте кадров, которая превышает частоту обновления экрана, могут появляться «разрывы» изображения, связанные с отсутствием синхронизации частот и спецификой обновления изображения у ЖК дисплеев – сверху вниз. Если ПК не обеспечивает стабильно высокий FPS, иногда новый кадр накладывается на старый, прежде чем тот исчезает с экрана. Появляется едва заметный эффект «разрыва» изображения на две части (его называют screen tearing от англ. слова to tear — рвать). Проблема особенно заметна при движениях в горизонтальной плоскости (например, при резких поворотах вправо и влево в шутерах). При этом, разрывы могут появляться даже на геймерских мониторах с частотой 120 или даже 144 Гц — просто они менее заметны.

|

| Наглядный пример эффекта screen tearing |

Многие годы проблему можно было частично решить включением вертикальной синхронизации (Vsync), которая заставляет графический адаптер «придержать» кадр, пока монитор не будет готов его отобразить. При этом максимальное количество кадров ограничивается частотой обновления экрана. Так что при устранении разрывов увеличивается задержка вывода изображения, которую можно ощутить, когда частота падает ниже поддерживаемой частоты обновления. К тому же, некоторые кадры будут обрабатываться графическим адаптером медленнее, так что монитору даже приходится ждать новые кадры, поэтому отображаются старые кадры, создается ощущение, что дисплей «заикается». Мало того, в тяжелых игровых сценах, когда видеокарте нужно работать более усердно, заметны проседания частоты кадров, что также может испортить впечатления от игрового процесса.

G-Sync и FreeSync – отличия и особенности

Чтобы избавиться от ограничений, вызванных вертикальной синхронизацией, главные производители графических адаптеров NVIDIA и AMD представили свои решения в этой области – G-Sync и FreeSync соответственно. Первая появилась в середине 2014 года, а вторая – весной 2015. Обе технологии работают с интерфейсом DisplayPort 1.2, как со стороны видеокарты, так и со стороны монитора. Компания AMD уже работает над возможностью интеграции технологии в интерфейс HDMI. Вне зависимости от производителя и особенностей реализации G-Sync и FreeSync, в основе обеих технологий лежит принцип изменения частоты обновления экрана. Причем выполняется он таким образом, что монитор может динамически подстраивать частоту обновления своего экрана под частоту кадров видеокарты. При этом частоты идеально синхронизированы, так что пользователь избавлен от разрывов изображения и визуальных багов, связанных с Vsync или видимых без ее использования.

Несмотря на то, что в основе этих технологий лежит одна идея, реализация отличается. Так, для работы G-Sync требуется отдельный проприетарный модуль, который устанавливается в монитор. Поскольку он стоит дорого, цена мониторов с G-Sync на несколько сотен долларов выше. Кроме этого, модули G-Sync поддерживают режим уменьшения размытия движения, который именуется Ultra Low Motion Blur (ULMB). Это позволяет пользователю выбрать режим работы подсветки дисплея для снижения до минимума «смазывания» картинки в движении (свойство ЖК-дисплеев). По отзывам, польза наиболее ощущается в стратегиях. Правда, две технологии пока что не работают одновременно, так как ULMB требуется постоянная частота обновления экрана. Ну и, конечно же, G-Sync совместима только с определенными видеокартами NVIDIA. Вот их список (по состоянию на лето 2015 года): TITAN Black и X, GeForce GTX 980, 970, 780 Ti, 780, 770, 760, 750 Ti, 750, 660, 680, 670, 690, 660 Ti и 650 Ti BOOST.

AMD FreeSync условно бесплатна для производителей мониторов, так как, благодаря компании VESA в интерфейс DisplayPort уже имплементирована спецификация Adaptive-Sync, которую и использует AMD. Большинство производителей мониторов уже имели нужные компоненты, но им не хватало правильного программного обеспечения для раскрытия всего потенциала технологии. Все обошлось без лицензирования, проприетарных компонентов и повышения цены. Все ради потребителей? Почти. Ведь без покупки современной видеокарты AMD не обойтись: Radeon R9 Fury X, R9 300 серии, R9 295X2, 290X, R9 290, R9 285, R7 260X или R7 260. У старых серий карт Radeon HD 7000, HD 8000 и других моделей R7 и R9, а также у части гибридных процессоров (APU) поддержка технологии не полная — в видео, но не играх. То есть на практике геймеры не ощутят пользы.

|

| Модуль, который устанавливается в мониторы с поддержкой G-Sync |

Поэтому особенности этой технологии немного другие. Благодаря отсутствию отдельного модуля производители мониторов не ограничены только разъемом DisplayPort, можно также установить HDMI, DVI, D-Sub для разнообразных подключений, даже несмотря на то, что FreeSync работает только с DisplayPort. С другой стороны, отсутствует функция уменьшения размытия, так что производители мониторов будут сами решать, добавлять ее или нет. Кроме этого, FreeSync совместима с небольшим количеством видеокарт AMD и не работает с графикой NVIDIA и Intel.

Первые мониторы с G-Sync: Acer XB270HU, XB280HK, XB270HA, XB240HAbpr, Asus PG278Q, BenQ XL2420G, AOC G2460PG.

Первые мониторы с FreeSync: Acer XG270HU и XR341CK, AOC G2460PF и G2770PF, Asus MG279Q и MG278Q, BenQ XL2730Z, LG 29UM67.

Системные требования касаются не только «железа». Надо установить на ПК Windows 7 или более новую версию, а также свежую версию драйверов для графического адаптера. Также для работы этих технологий нужно активировать функцию в NVIDIA Control Panel или AMD Catalyst Control Center. Собственно, насчет игр ограничений нет — в большинстве проектов с 3D графикой польза будет заметна.

Первые впечатления

Что касается реальных условий эксплуатации, то обе технологии зарекомендовали себя только с положительной стороны. Такое впечатление складывается по обзорам первых мониторов, совместимых с G-Sync или FreeSync. Возможно, польза заметна не всегда (не во всех играх, не на всех настройках графики и т. д.), однако, в целом обозреватели положительно оценивают эффект от G-Sync и FreeSync в шутерах, ролевых играх, автосимуляторах и играх других жанров.

G-Sync показывает наилучшие результаты при FPS в пределах 45-60 кадров/с, а для FreeSync этот показатель составляет 40-75 кадров/с. То есть в тех условиях, при которых играют обычные люди, а не киберспортсмены. При этом для технологии FreeSync даже можно включить Vsync, если система достаточно производительна, чтобы выйти за рамки возможностей поддерживаемого монитора. Тем не менее, при приближении к частоте 144 Гц, польза технологий не так ощутима, хотя все-равно заметна. Тесты показывают, что производительность системы с включенной FreeSync на доли процента выше, чем без нее. С другой стороны, G-Sync уменьшает количество FPS на пару кадров, что едва-ли заметно в играх. Так что не стоит волноваться, что дополнительная нагрузка на систему при активизации этих технологий сильно повлияет на ее производительность в играх.

Резюме

Простого ответа на вопрос «Что лучше – G-Sync или FreeSync?» нет. Все сводится к выбору производителя – NVIDIA или AMD. Учитывая, что единого стандарта нет, то нужно подстраиваться под существующую систему или собирать новую. Технология AMD существенно дешевле и намного удобнее для реализации со стороны производителей мониторов, хотя это и не значит, что дисплеи с поддержкой FreeSync заполнят рынок. Все дело в том, что примерно 3 из 4 проданных дискретных видеокарт (без учета графики, встроенной в процессоры) имеют процессор NVIDIA. Так что производители мониторов точно не обойдут стороной G-Sync, даже несмотря на повышение стоимости конечного продукта. Не будем забывать о бонусе в виде технологии ULMB, уменьшающей размытие при движении объектов на экране, которая во многих случаях тоже полезна, как и адаптивная частота развертки. Пусть мониторы с G-Sync или FreeSync пока еще дорогие и их мало, однако в скором будущем эти технологии могут стать массовыми и, возможно, на их основе появится универсальная технология — для всех видеокарт и мониторов. А пока самые требовательные геймеры могут увидеть какой эффект дают новые разработки уже сейчас. и возвращаться к играм «по старому», судя по отзывам очевидцев, многие из них уже не захотят.